A robots .txt 파일에는 검색 엔진에 대한 지시문이 포함되어 있습니다. 이를 사용하여 검색 엔진이 웹 사이트의 특정 부분을 크롤링하는 것을 방지하고 검색 엔진이 웹 사이트를 가장 잘 크롤링 할 수있는 방법에 대한 유용한 팁을 제공 할 수 있습니다. robots.txt 파일은 SEO에서 큰 역할을합니다.

robots.txt를 구현할 때 다음 모범 사례를 염두에 두십시오.

- robots.txt :이 파일은 웹 사이트의 대부분을 검색 엔진에서 액세스 할 수 없게 만들 수 있습니다.

- robots.txt 파일은 웹 사이트의 루트에 있어야합니다 (예 : 또는

https). - 검색 엔진에 따라 명령어가 다르게 해석됩니다. 기본적으로 첫 번째 일치하는 지시문이 항상 이깁니다. 하지만 Google과 Bing에서는 특이성이 우선합니다.

- 검색 엔진에 크롤링 지연 지시문을 가능한 한 사용하지 마십시오.

robots.txt 파일?

robots.txt 파일은 웹 사이트의 참여 규칙을 검색 엔진에 알려줍니다. SEO를 수행하는 데있어 가장 중요한 부분은 검색 엔진에 올바른 신호를 보내는 것이며 robots.txt는 크롤링 환경 설정을 검색 엔진에 전달하는 방법 중 하나입니다.

2019 년에 우리는 꽤 많은 것을 보았습니다. robots.txt 표준에 대한 일부 개발 : Google은 로봇 배제 프로토콜에 대한 확장을 제안하고 robots.txt 파서를 오픈 소스했습니다.

TL; DR

- Google의 로봇 .txt 인터프리터는 매우 유연하고 놀랍도록 관대합니다.

- 혼란 지시문의 경우 Google은 안전한 측면에서 오류를 일으키고 섹션이 제한되지 않고 제한되어야한다고 가정합니다.

검색 엔진은 정기적으로 웹 사이트의 robots.txt 파일을 확인하여 웹 사이트를 크롤링하기위한 지침이 있는지 확인합니다. 이러한 지침을 지침이라고합니다.

robots.txt 파일이 없거나 적용 가능한 지침이없는 경우 검색 엔진은 전체 웹 사이트를 크롤링합니다.

모든 주요 검색 엔진이 존중하지만 robots.txt 파일의 경우 검색 엔진은 robots.txt 파일 (일부)을 무시하도록 선택할 수 있습니다. robots.txt 파일의 명령어는 검색 엔진에 대한 강력한 신호이지만 robots.txt 파일은 명령이 아니라 검색 엔진에 대한 선택적 명령어 집합임을 기억하는 것이 중요합니다.

robots.txt는 SEO 분야에서 가장 민감한 파일입니다. 한 문자가 전체 사이트를 망칠 수 있습니다.

robots.txt 파일 관련 용어

robots.txt 파일은 로봇 제외 표준을 구현하거나 로봇 배제 프로토콜.

robots.txt에 관심을 가져야하는 이유는 무엇입니까?

robots.txt는 SEO 관점에서 중요한 역할을합니다. 검색 엔진이 웹 사이트를 가장 잘 크롤링 할 수있는 방법을 알려줍니다.

robots.txt 파일을 사용하면 검색 엔진이 웹 사이트의 특정 부분에 액세스하는 것을 방지하고, 중복 콘텐츠를 방지하고, 검색 엔진에 유용한 정보를 제공 할 수 있습니다. 웹 사이트를 더 효율적으로 크롤링 할 수 있습니다.

하지만 robots.txt를 변경할 때는주의하세요.이 파일은 웹 사이트의 대부분을 검색 엔진에서 액세스하지 못하게 만들 수 있습니다.

Robots.txt는 중복 콘텐츠를 줄이기 위해 너무 많이 사용되므로 내부 연결을 죽이기 때문에 정말 조심해야합니다. 내 조언은 검색 엔진이 절대 볼 수없는 파일이나 페이지에만 사용하거나 허용 됨으로써 크롤링에 큰 영향을 미칠 수 있다는 것입니다. 일반적인 예 : 다양한 URL을 생성하는 로그인 영역, 테스트 영역 또는 여러 패싯 탐색이 존재할 수있는 위치. 그리고 문제 나 변경 사항이 있는지 robots.txt 파일을 모니터링하십시오.

robots.txt 파일에서 보는 대부분의 문제는 다음 세 가지 버킷으로 분류됩니다.

- 와일드 카드의 잘못된 처리. 차단하려는 의도로 차단 된 사이트의 일부를 보는 것은 매우 일반적입니다. 때로는주의하지 않으면 지시문이 서로 충돌 할 수도 있습니다.

- 개발자와 같은 누군가가 갑자기 변경 (종종 새 코드를 푸시 할 때)하고 실수로 변경했습니다. 알지 못하는 사이 robots.txt.

- robots.txt 파일에 속하지 않는 명령어를 포함합니다. Robots.txt는 웹 표준이며 다소 제한적입니다. 개발자가 (적어도 대부분의 크롤러에 대해) 작동하지 않는 지시문을 만드는 것을 자주 봅니다. 때로는 무해하고 때로는 그다지 많지 않습니다.

예

이를 설명하는 예를 살펴 보겠습니다.

당신 ‘전자 상거래 웹 사이트를 운영하고 있으며 방문자는 필터를 사용하여 제품을 빠르게 검색 할 수 있습니다. 이 필터는 기본적으로 다른 페이지와 동일한 콘텐츠를 표시하는 페이지를 생성합니다. 이는 사용자에게 효과적이지만 중복 콘텐츠를 생성하기 때문에 검색 엔진을 혼동합니다.

검색 엔진이 필터링 된 페이지의 색인을 생성하고 필터링 된 콘텐츠로 이러한 URL에 소중한 시간을 낭비하는 것을 원하지 않습니다. 따라서 검색 엔진이 필터링 된 제품 페이지에 액세스하지 못하도록 Disallow 규칙을 설정해야합니다.

표준 URL을 사용하여 중복 콘텐츠를 방지 할 수도 있습니다. 하지만 메타 로봇 태그는 검색 엔진이 중요한 페이지 만 크롤링하도록 허용하지 않습니다.

표준 URL 또는 메타 로봇 태그를 사용해도 검색 엔진이 이러한 페이지를 크롤링하는 것을 막지는 않습니다. 검색 엔진이 검색 결과에 이러한 페이지를 표시하지 못하도록합니다. 검색 엔진은 웹 사이트를 크롤링하는 데 시간이 제한되어 있으므로 이번에는 검색 엔진에 표시하려는 페이지에 시간을 투자해야합니다.

잘못 설정된 robots.txt 파일로 인해 SEO 성능이 저하 될 수 있습니다. 귀하의 웹 사이트에 해당하는지 즉시 확인하십시오!

매우 간단한 도구이지만 robots.txt 파일이 올바르게 구성되지 않은 경우 특히 많은 문제가 발생할 수 있습니다. 더 큰 웹 사이트를 위해. 새로운 디자인이나 CMS가 출시 된 후 전체 사이트를 차단하거나 비공개로 설정해야하는 사이트 섹션을 차단하지 않는 등의 실수는 매우 쉽습니다. 대규모 웹 사이트의 경우 Google 크롤링을 효율적으로 유지하는 것이 매우 중요하며 잘 구성된 robots.txt 파일은 그 과정에서 필수적인 도구입니다.

사이트의 어떤 섹션이 가장 잘 보관되는지 이해하려면 시간을 할애해야합니다. Google에서 최대한 많은 리소스를 사용하여 사용자가 정말로 관심있는 페이지를 크롤링하도록합니다.

robots.txt 파일은 어떻게 생겼습니까?

WordPress 웹 사이트를위한 간단한 robots.txt 파일의 예 모양 :

위의 예를 기반으로 robots.txt 파일의 구조를 설명하겠습니다.

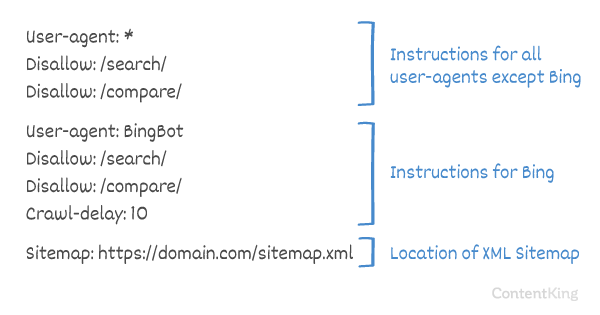

- User-agent :

user-agent는 검색 대상을 나타냅니다. 엔진은 다음 지시문을 의미합니다. -

*: 이는 지시문이 모든 검색 엔진을 의미 함을 나타냅니다. -

Disallow:user-agent에 액세스 할 수없는 콘텐츠를 나타내는 지시문입니다. -

/wp-admin/:user-agent에 액세스 할 수없는path입니다.

요약 :이 robots.txt 파일은 모든 검색 엔진에 /wp-admin/ 디렉토리를 벗어나도록 지시합니다.

다른 정보를 분석해 보겠습니다. robots.txt 파일의 구성 요소에 대한 자세한 정보 :

- User-agent

- 금지

- 허용

- 사이트 맵

- 크롤링 지연

robots.txt의 User-agent

각 검색 엔진은 user-agent. 예를 들어 Google의 로봇은 Googlebot로 식별되고 Yahoo의 로봇은 Slurp로, Bing의 로봇은 BingBot로 식별됩니다. 등등.

user-agent 레코드는 지시어 그룹의 시작을 정의합니다. 첫 번째 user-agent와 다음 user-agent 레코드 사이의 모든 지침은 첫 번째 user-agent.

지시문은 특정 사용자 에이전트에 적용 할 수 있지만 모든 사용자 에이전트에도 적용 할 수 있습니다. 이 경우 와일드 카드가 사용됩니다. User-agent: *.

robots.txt의 Disallow 지시문

검색 엔진에 액세스하지 않도록 지시 할 수 있습니다. 웹 사이트의 특정 파일, 페이지 또는 섹션. 이는 Disallow 지시문을 사용하여 수행됩니다. Disallow 지시문 뒤에는 액세스해서는 안되는 path가옵니다. path가 정의되어 있지 않으면 지시문이 무시됩니다.

예

이 예에서 모든 검색 엔진은 /wp-admin/ 디렉토리에 액세스하지 않도록 지시합니다.

robots.txt에서 지시문 허용

Allow 지시문은 Disallow 지시문에 대응하는 데 사용됩니다. Allow 지시문은 Google 및 Bing에서 지원합니다. Allow 및 Disallow 명령어를 함께 사용하면 검색 엔진에서 허용되지 않는 디렉토리 내의 특정 파일이나 페이지에 액세스 할 수 있음을 검색 엔진에 알릴 수 있습니다. Allow 지시문 뒤에는 액세스 할 수있는 path가옵니다. path가 정의되어 있지 않으면 지시문이 무시됩니다.

예

위의 예에서 모든 검색 엔진은 디렉토리 (/media/terms-and-conditions.pdf 파일 제외).

중요 : Allow 및

지시문을 함께 사용하는 경우, 지시문 충돌이 발생할 수 있으므로 와일드 카드를 사용하지 마십시오.

충돌 지시문의 예

검색 엔진은 URL로 무엇을해야하는지 알지 못합니다. . 액세스가 허용되는지 여부는 명확하지 않습니다. 지시문이 Google에 명확하지 않은 경우 가장 제한적인 지시문을 사용합니다.이 경우 실제로

Disallow rules in a site’s robots.txt file are incredibly powerful, so should be handled with care. For some sites, preventing search engines from crawling specific URL patterns is crucial to enable the right pages to be crawled and indexed – but improper use of disallow rules can severely damage a site’s SEO.

A separate line for each directive

Each directive should be on a separate line, otherwise search engines may get confused when parsing the robots.txt file.

Example of incorrect robots.txt file

Prevent a robots.txt file like this:

User-agent: * Disallow: /directory-1/ Disallow: /directory-2/ Disallow: /directory-3/

Robots.txt는 가장 일반적으로 잘못 구현 된 기능 중 하나이므로 차단하려는 항목을 차단하지 않거나 예상보다 더 많이 차단하고 웹 사이트에 부정적인 영향을 미칩니다. Robots.txt는 매우 강력한 도구이지만 너무 자주 잘못 설정됩니다.

와일드 카드 사용 *

와일드 카드는 user-agent를 정의하는 데 사용할 수있을뿐만 아니라 다음 용도로도 사용할 수 있습니다. 일치 URL. 와일드 카드는 Google, Bing, Yahoo 및 Ask에서 지원됩니다.

예

위의 예에서 모든 검색 엔진은 물음표가 포함 된 URL (?).

개발자 또는 사이트 소유자는 종종 robots.txt 파일에서 모든 유형의 정규 표현식을 활용할 수 있다고 생각하는 것처럼 보이지만 실제로는 매우 제한된 양의 패턴 일치 만 유효합니다 (예 : 와일드 카드 (

*). .htaccess 파일과 robots.txt 파일 사이에 때때로 혼동이있는 것 같습니다.

URL 끝 사용 $

URL 끝을 나타내려면 달러 기호 ($) path의 끝에 있습니다.

예

위의 예에서 검색 엔진은 .php로 끝나는 모든 URL에 액세스 할 수 없습니다. . 매개 변수가있는 URL (예 : URL이 .php 이후에 끝나지 않으므로 는 허용되지 않습니다.

로봇에 사이트 맵을 추가합니다. txt

robots.txt 파일은 검색 엔진에 크롤링하지 말아야 할 페이지를 알리기 위해 만들어졌지만 robots.txt 파일을 사용하여 검색 엔진이 XML 사이트 맵을 가리 키도록 할 수도 있습니다. 이는 Google, Bing, Yahoo 및 Ask에서 지원됩니다.

XML 사이트 맵은 절대 URL로 참조되어야합니다. URL이 robots.txt 파일과 동일한 호스트에있을 필요는 없습니다.

robots.txt 파일에서 XML 사이트 맵을 참조하는 것은 Google에서 항상 권장하는 모범 사례 중 하나입니다. Google Search Console 또는 Bing 웹 마스터 도구에서 XML 사이트 맵을 이미 제출했을 수 있습니다. 더 많은 검색 엔진이 있다는 것을 기억하십시오.

robots.txt 파일에서 여러 XML 사이트 맵을 참조 할 수 있습니다.

예

다중 robots.txt 파일에 정의 된 XML 사이트 맵 :

로봇에 정의 된 단일 XML 사이트 맵입니다.txt 파일 :

위의 예는 모든 검색 엔진이 /wp-admin/ 디렉토리에 액세스하지 않도록 지시하며 XML 사이트 맵은

Comments are preceded by a #에서 찾을 수 있으며 행의 시작 또는 같은 행의 지시문 뒤에 위치합니다. # 이후의 모든 항목은 무시됩니다. 이 댓글은 사람을위한 것입니다.

예 1

예제 2

위의 예는 동일한 메시지를 전달합니다.

robots.txt의 크롤링 지연

Crawl-delay 지시문은 너무 많은 요청으로 서버 과부하를 방지하는 데 사용되는 비공식 지시문입니다. 검색 엔진이 서버에 과부하를 줄 수있는 경우 robots.txt 파일에 Crawl-delay를 추가하는 것은 일시적인 수정일뿐입니다. 문제는 웹 사이트가 열악한 호스팅 환경에서 실행 중이거나 웹 사이트가 잘못 구성되어 있다는 것입니다. 가능한 한 빨리 수정해야합니다.

검색 엔진이 Crawl-delay를 처리하는 방식이 다릅니다. 아래에서는 주요 검색 엔진이이를 처리하는 방법에 대해 설명합니다.

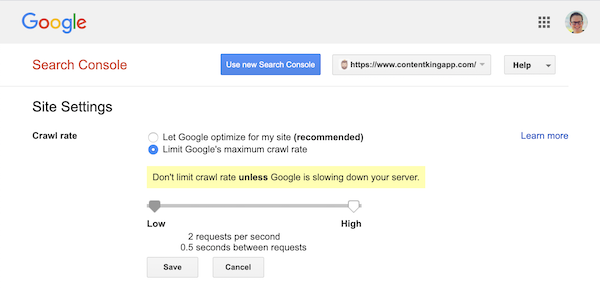

크롤링 지연 및 Google

Google의 크롤러 인 Googlebot은 Crawl-delay 명령어이므로 Google 크롤링 지연 정의에 신경 쓰지 마세요.

하지만 Google은 크롤링 속도 (또는 원하는 경우 ‘요청 속도’) 정의를 지원합니다. ) Google Search Console에서.

- 이전 Google Search Console에 로그인합니다.

- 웹 사이트 선택 크롤링 속도를 정의하려고합니다.

- 조정할 수있는 설정은

Crawl rate이며 원하는 크롤링 속도를 설정할 수있는 슬라이더가 있습니다. 기본적으로 크롤링 속도가 ‘Google이 내 사이트에 최적화하도록 허용 (권장)’으로 설정되어 있습니다.

Google Search Console에 표시되는 모습은 다음과 같습니다.

크롤링 지연 및 Bing, Yahoo 및 Yandex

Bing, Yahoo 및 Yandex 모두 Crawl-delay 지시문은 웹 사이트 크롤링을 제한합니다. 크롤링 지연에 대한 해석은 약간 다르므로 설명서를 확인하십시오.

- Bing 및 Yahoo

- Yandex

Crawl-delay 지시문은 Disallow 또는 Allow 지시문 바로 뒤에 배치해야합니다.

예 :

Crawl-delay 및 Baidu

Baidu는 crawl-delay 지시문을 지원하지 않지만 Baidu 웹 마스터 도구 계정을 다음에서 등록 할 수 있습니다. Google Search Console과 유사하게 크롤링 빈도를 제어 할 수 있습니다.

robots.txt 파일은 언제 사용하나요?

항상 robots.txt 파일을 사용하는 것이 좋습니다. 웹 사이트를 가장 잘 크롤링 할 수있는 방법에 대한 검색 엔진 지침을 전달하기에 좋은 곳입니다.

robots.txt는 사이트의 특정 영역이나 문서가 크롤링 및 색인 생성되지 않도록하는 데 유용 할 수 있습니다. 예를 들어 스테이징 사이트 또는 PDF가 있습니다. 검색 엔진에서 색인을 생성해야하는 항목을 신중하게 계획하고 robots.txt를 통해 액세스 할 수 없게 된 콘텐츠가 웹 사이트의 다른 영역에서 링크 된 경우 검색 엔진 크롤러가 여전히 찾을 수 있다는 점에 유의하세요.

Robots.txt 모범 사례

robots.txt 권장 사항은 다음과 같이 분류됩니다.

- 위치 및 파일 이름

- 우선 순위

- 로봇 당 하나의 명령어 그룹

- 위치 및 파일 이름

- 최대한 구체적이어야합니다.

- 특정 로봇에 대한 지침도 포함하면서 모든 로봇에 대한 지침

- 각 (하위) 도메인에 대한 Robots.txt 파일

- 상충되는 가이드 라인 : robots.txt와 Google Search Console 비교

- robots.txt 파일 모니터링

- robots.txt에서 noindex를 사용하지 마세요

- robots.txt 파일에서 UTF-8 BOM 방지

li>

위치 및 파일 이름

robots.txt 파일은 항상 다음 위치에 있어야합니다. e 웹 사이트의

root(호스트의 최상위 디렉토리에 있음) 및 파일 이름robots.txt(예 :. robots.txt 파일의 URL은 다른 URL과 마찬가지로 대소 문자를 구분합니다.기본 위치에서 robots.txt 파일을 찾을 수없는 경우 검색 엔진은 명령어가 없다고 가정하고 웹 사이트에서 크롤링합니다.

우선 순위

검색 엔진은 robots.txt 파일을 다르게 처리한다는 점에 유의해야합니다. 기본적으로 첫 번째 일치하는 지시문이 항상 승리합니다.

그러나 Google 및 Bing 특이성이 승리합니다. 예 :

Allow지시문은 문자 길이가 더 길면Disallow지시문보다 우선합니다.예

위의 예는 Google 및 Bing을 포함한 모든 검색 엔진에서

/about/company/하위 디렉토리를 제외한/about/디렉토리에 액세스 할 수 없습니다.예

위의 예에서 Google 및 Bing을 제외한 모든 검색 엔진은

/about/디렉토리에 대한 액세스가 허용되지 않습니다. 여기에는/about/company/디렉토리가 포함됩니다.Google 및 Bing은 액세스가 허용됩니다.

Allow지시문이Disallow지시문.로봇 당 지시문 그룹 하나만

검색 엔진 당 지시문 그룹 하나만 정의 할 수 있습니다. 하나의 검색 엔진에 대해 여러 그룹의 지시문이 있으면 혼란 스럽습니다.

최대한 구체적으로 작성하십시오.

Disallow지시문은 다음과 같이 부분 일치에서 트리거됩니다. 잘. 의도하지 않게 파일에 대한 액세스를 허용하지 않도록Disallow지시문을 정의 할 때 최대한 구체적으로 작성하세요.예 :

위의 예에서는 검색 엔진이 다음에 대한 액세스를 허용하지 않습니다.

-

/directory -

/directory/ -

/directory-name-1 -

/directory-name.html -

/directory-name.php -

/directory-name.pdf

특정 로봇에 대한 지침도 포함하는 동시에 모든 로봇에 대한 지침

로봇의 경우 한 그룹의 지시문 만 유효합니다. 모든 로봇에 대한 지침이 특정 로봇에 대한 지침과 함께 뒤 따르는 경우 이러한 특정 지침 만 고려됩니다. 특정 로봇이 모든 로봇에 대한 지침을 따르려면 특정 로봇에 대해 이러한 지침을 반복해야합니다.

이를 명확히하는 예를 살펴 보겠습니다.

예

Googlebot이

/secret/및/not-launched-yet/에 액세스하지 않도록하려면googlebot구체적 :robots.txt 파일은 공개적으로 사용할 수 있습니다. 웹 사이트 섹션을 허용하지 않는 것은 악의적 인 의도를 가진 사람들의 공격 벡터로 사용될 수 있습니다.

Robots.txt는 위험 할 수 있습니다. 검색 엔진이 보지 않기를 바라는 곳을 알려주는 것뿐만 아니라 더러운 비밀을 숨긴 곳을 사람들에게 알려주는 것입니다.

LinkedInPatrick Stox, Raleigh 기반 기술 SEO각 (하위) 도메인에 대한 Robots.txt 파일

Robots.txt 지시문 만 파일이 호스팅되는 (하위) 도메인에 적용됩니다.

예

는 (또는It’s a best practice to only have one robots.txt file available on your (sub)domain.

If you have multiple robots.txt files available, be sure to either make sure they return a HTTP status 404, or to 301 redirect them to the canonical robots.txt file.

Conflicting guidelines: robots.txt vs. Google Search Console

In case your robots.txt file is conflicting with settings defined in Google Search Console, Google often chooses to use the settings defined in Google Search Console over the directives defined in the robots.txt file.

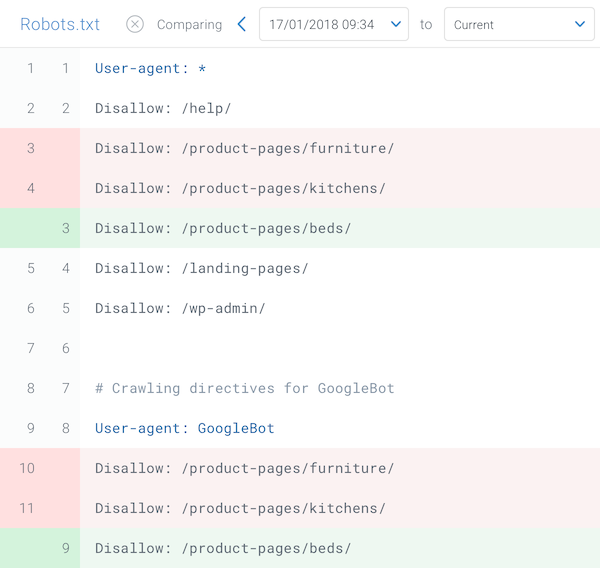

Monitor your robots.txt file

It’s important to monitor your robots.txt file for changes. At ContentKing, we see lots of issues where incorrect directives and sudden changes to the robots.txt file cause major SEO issues.

This holds true especially when launching new features or a new website that has been prepared on a test environment, as these often contain the following robots.txt file:

User-agent: *Disallow: /제외)

Google은 이러한 이유로 robots.txt 변경 추적 및 경고를 구축했습니다.

robots.txt가 언제 변경되는지 어떻게 알 수 있나요?

robots.txt가 언제 변경되는지 어떻게 알 수 있나요?항상 확인하고 있습니다. robots.txt 파일은 디지털 마케팅 지식 없이도 변경됩니다. 팀. 그 사람이되지 마십시오. 이제 robots.txt 파일 모니터링을 시작하면 파일이 변경되면 알림이 전송됩니다.

robots.txt에서 noindex를 사용하지 마세요.

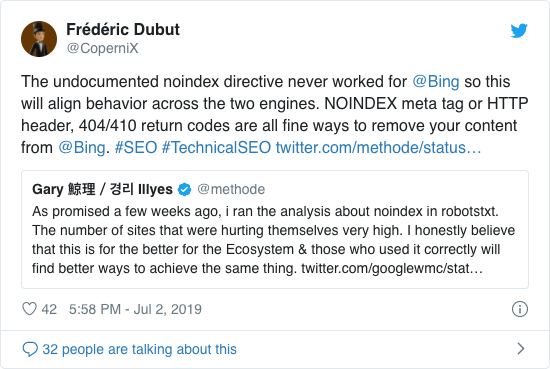

Google은 이미 수년 동안 비공식적 인 NOINDEX 지침 사용을 공개적으로 권장했습니다. 그러나 2019 년 9 월 1 일부터 Google은이를 완전히 지원하지 않았습니다.

Frédéric Dubut가 다음 트윗에서 확인한 것처럼 비공식적 인 NOINDEX 지침은 Bing에서 작동하지 않았습니다.

페이지의 색인이 생성되지 않아야한다는 것을 검색 엔진에 알리는 가장 좋은 방법은 메타 로봇 태그 또는 X-Robots-Tag를 사용하는 것입니다. .

자주 묻는 질문robots.txt 파일에서 UTF-8 BOM 방지

BOM은 바이트 순서 표시를 나타냅니다. 텍스트 파일의 유니 코드 인코딩을 나타내는 데 사용되는 파일입니다.

Google은 robots.txt 파일의 시작 부분에있는 선택적 유니 코드 바이트 순서 표시를 무시한다고 명시하고 있지만 “UTF-8 BOM”이 해석에 문제를 일으키는 것으로 확인 했으므로 방지하는 것이 좋습니다. 검색 엔진의 robots.txt 파일입니다.

Google에서 처리 할 수 있다고 말했지만 UTF-8 BOM을 방지하는 두 가지 이유는 다음과 같습니다.

- 검색 엔진 크롤링에 대한 선호도에 대한 모호함을 원치 않습니다.

- Google의 주장만큼 관용적이지 않은 다른 검색 엔진도 있습니다.

Robots.txt 예제

이 장에서는 광범위한 robots.txt 파일 예제를 다룰 것입니다.

- 모든 로봇이 모든 항목에 액세스하도록 허용

- 모든 로봇이 모든 항목에 액세스하는 것을 허용하지 않음

- 모든 Google 봇이 액세스 권한이 없습니다.

- Googlebot 뉴스를 제외한 모든 Google 봇이 액세스 권한이 없음

- Googlebot 및 Slurp는 액세스 권한이 없습니다.

- 모든 로봇은 두 개에 액세스 할 수 없습니다. 디렉토리

- 모든 로봇은 하나의 특정 파일에 액세스 할 수 없습니다.

- Googlebot은 / admin /에 액세스 할 수 없으며 Slurp는 / private /에 액세스 할 수 없습니다.

- WordPress 용 Robots.txt 파일

- Magento 용 Robots.txt 파일

모든 로봇이 모든 항목에 액세스하도록 허용

여러 가지 방법이 있습니다. 검색 엔진에 모든 파일에 액세스 할 수 있음을 알리려면 :

또는 robots.txt 파일이 비어 있거나 robots.txt가 전혀 없습니다.

모든 로봇이 모든 항목에 액세스하는 것을 허용하지 않습니다.

예 아래의 robots.txt는 모든 검색 엔진이 전체 사이트에 액세스하지 않도록 지시합니다.

하나의 추가 문자만으로 모든 차이를 만들 수 있습니다.

모든 Google 봇은 액세스 권한이 없습니다.

Googlebot을 허용하지 않으면 모든 Googlebot에 적용됩니다. 여기에는 뉴스 (

googlebot-news) 및 이미지 (googlebot-images)를 검색하는 Google 로봇이 포함됩니다.모두 Googlebot 뉴스를 제외한 Google 봇은 액세스 권한이 없습니다.

Googlebot 및 Slurp에 액세스 권한이 없습니다.

모든 로봇이 두 개의 디렉토리에 액세스 할 수 없습니다.

모든 로봇이 하나의 특정 파일에 액세스 할 수 없습니다.

Googlebot은 /에 액세스 할 수 없습니다. admin / 및 Slurp는 / private /

자주 묻는 질문Robots.txt WordPress 용 파일

아래 robots.txt 파일은 특별히 WordPress에 최적화되어 있으며 다음과 같은 가정을 전제로합니다.

- 관리 섹션이 크롤링되는 것을 원하지 않습니다.

- li>

- 내부 검색 결과 페이지가 크롤링되는 것을 원하지 않습니다.

- 태그 및 작성자 페이지가 크롤링되는 것을 원하지 않습니다.

- 그렇지 않습니다. 404 페이지가 크롤링되기를 원합니다.

이 robots.txt 파일은 대부분의 경우 작동하지만 항상 파일을 조정하고 테스트하여 정확한 상황.

Magento 용 Robots.txt 파일

아래의 robots.txt 파일은 Magento에 특별히 최적화되어 있으며 내부 검색 결과, 로그인 페이지, 세션 식별자 및 필터링 된 결과를 만듭니다.

price,color,material및size기준은 크롤러가 액세스 할 수 없습니다.이 robots.txt 파일은 대부분의 Magento 스토어에서 작동하지만 항상 조정하고 테스트하여 정확한 상황에 적용되는지 테스트해야합니다.

유용한 리소스

이러한 유형의 검색 URL은 무한하고 무한한 공백이기 때문에 모든 사이트에서 robots.txt의 내부 검색 결과를 차단하려고합니다. Googlebot이 크롤러 함정에 빠질 가능성은 많습니다.

Dawn Anderson, Berteyrobots.txt 파일의 제한 사항은 무엇입니까?

Robots.txt 파일에는 지시문이 포함되어 있습니다.

검색시 robots.txt가 잘 존중되지만 엔진의 경우 여전히 지시문이며 명령이 아닙니다.

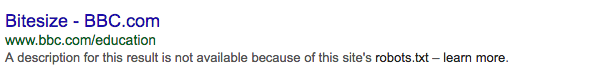

검색 결과에 여전히 나타나는 페이지

로봇으로 인해 검색 엔진에서 액세스 할 수없는 페이지.txt이지만 크롤링되는 페이지에서 링크 된 경우 해당 링크가 검색 결과에 계속 나타날 수 있습니다. 예 :

프로 팁

프로 팁Google Search Console의 URL 삭제 도구를 사용하여 Google에서 이러한 URL을 삭제할 수 있습니다. 이러한 URL은 일시적으로 “숨겨집니다”. Google 결과 페이지에 표시되지 않으려면 180 일마다 URL 숨기기 요청을 제출해야합니다.

robots.txt를 사용하여 바람직하지 않거나 유해 할 가능성이있는 제휴 백 링크를 차단하세요. 검색 엔진에서 콘텐츠의 색인이 생성되는 것을 방지하기 위해 robots.txt를 사용하지 마십시오. 이는 불가피하게 실패 할 수 있습니다. 대신 필요한 경우 로봇 지시문 noindex를 적용하세요.

Fili Wiese, SearchBrothersRobots.txt 파일은 최대 24 시간 동안 캐시됩니다.

Google은 로봇이 .txt 파일은 일반적으로 최대 24 시간 동안 캐시됩니다. robots.txt 파일을 변경할 때이 점을 고려하는 것이 중요합니다.

다른 검색 엔진이 robots.txt의 캐시를 처리하는 방법이 명확하지 않습니다. 이지만 일반적으로 robots.txt 파일을 av에 캐싱하지 않는 것이 가장 좋습니다. oid 검색 엔진이 변경 사항을 적용하는 데 필요한 것보다 오래 걸립니다.

Robots.txt 파일 크기

robots.txt 파일의 경우 Google은 현재 500KB의 파일 크기 제한을 지원합니다. (512 킬로바이트). 이 최대 파일 크기 이후의 모든 콘텐츠는 무시 될 수 있습니다.

다른 검색 엔진이 robots.txt 파일의 최대 파일 크기를 가지고 있는지 여부는 불분명합니다.

robots.txt에 대해 자주 묻는 질문

h2>

🤖 robots.txt 예제는 어떻게 생겼습니까?

다음은 robots.txt 콘텐츠의 예제입니다. User-agent : * Disallow :. 이렇게하면 모든 크롤러가 모든 것에 액세스 할 수 있습니다.

⛔ Disallow all은 robots.txt에서 무엇을합니까?

robots.txt를 “Disallow all”로 설정하면 기본적으로 모든 크롤러에게 차단을 지시합니다. Google을 포함한 어떤 크롤러도 귀하의 사이트에 액세스 할 수 없습니다. 즉, 사이트를 크롤링, 색인 생성 및 순위를 매길 수 없습니다. 이로 인해 자연 트래픽이 크게 감소합니다.

✅ robots.txt에서 모두 허용은 무엇입니까?

robots.txt를 “모두 허용”으로 설정하면 모든 크롤러가 사이트의 모든 URL에 액세스 할 수 있음을 알립니다. 연루의 규칙은 없습니다. 이것은 robots.txt가 비어 있거나 robots.txt가 전혀없는 것과 같습니다.

🤔 SEO에서 robots.txt가 얼마나 중요합니까?

In 일반적으로 robots.txt 파일은 SEO 목적에 매우 중요합니다. 대규모 웹 사이트의 경우 robots.txt는 검색 엔진에 액세스하지 말아야 할 콘텐츠에 대한 명확한 지침을 제공하는 데 필수적입니다.

추가 정보